如何使用Spark分析云HBase的數據-創新互聯

這篇文章將為大家詳細講解有關如何使用Spark分析云HBase的數據,小編覺得挺實用的,因此分享給大家做個參考,希望大家閱讀完這篇文章后可以有所收獲。

成都創新互聯是一家專業提供集賢企業網站建設,專注與網站建設、成都做網站、H5網站設計、小程序制作等業務。10年已為集賢眾多企業、政府機構等服務。創新互聯專業網站設計公司優惠進行中。1 云HBase查詢分析的現狀

HBase原生API:HBase原生API適合基于row key做點查,這個是HBase最擅長的查詢場景

Phoenix:Phoenix作為HBase的SQL層,使用二級索引的技術,擅長多條件組合查詢;Phoenix沒有自己的計算資源,類似groupby這樣的復雜查詢需要借助HBase的協處理器來完成,這樣一方面性能不好,同時會影響HBase集群的穩定性;

Spark:具有豐富的算子支持復雜分析,使用Spark集群的計算資源,通過并發分析的方式可以提高性能,同時不影響HBase集群的穩定性。

2 Spark分析HBase的方式對比

Spark分析HBase數據有“RDD API”、“SQL API”、“HFILE”三種方式,相關對比如下:

對于數據動態更新增加的小表推薦使用SQL API的方式,可以有效的優化分析,減少對HBase集群穩定性的影響;對于靜態表或者全量靜態表的分析推薦使用分析HFILE的方式直讀HDFS,這樣可以完全不影響HBase集群穩定性;不推薦使用RDD API 的方式,這種方式一方沒有優化性能差,同時在高并發以及表數據量大時,會嚴重影響HBase集群的穩定性,從而影響在線業務。

3 三種方式的具體使用

云HBase團隊為大家提供了一個github項目供大家參考使用上面的三種方式來開發Spark分析HBase的程序,項目地址:

https://github.com/lw309637554/alicloud-hbase-spark-examples?spm=a2c4e.11153940.blogcont573569.14.1b6077b4MNpI9X

依賴項:需要下載云HBase及云Phoenix的client包

分析HFILE:

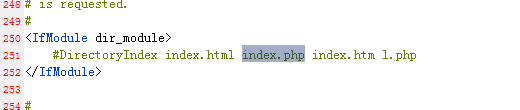

需要先開通云HBase的HDFS訪問權限,參考文檔

在hbase shell中對表生成snapshot表“snapshot 'sourceTable', ‘snapshotName'”

在項目中配置自己的hdfs-sit.xml文件,然后通過直讀HDFS的方式分析snapshot表

具體的example

RDD API對應:org.apache.spark.hbase.NativeRDDAnalyze

SQL API對應:org.apache.spark.sql.execution.datasources.hbase.SqlAnalyze

分析HFILE對應:org.apache.spark.hfile.SparkAnalyzeHFILE

關于“如何使用Spark分析云HBase的數據”這篇文章就分享到這里了,希望以上內容可以對大家有一定的幫助,使各位可以學到更多知識,如果覺得文章不錯,請把它分享出去讓更多的人看到。

新聞標題:如何使用Spark分析云HBase的數據-創新互聯

當前網址:http://m.kartarina.com/article6/ccgcig.html

成都網站建設公司_創新互聯,為您提供微信小程序、全網營銷推廣、響應式網站、服務器托管、自適應網站、動態網站

聲明:本網站發布的內容(圖片、視頻和文字)以用戶投稿、用戶轉載內容為主,如果涉及侵權請盡快告知,我們將會在第一時間刪除。文章觀點不代表本網站立場,如需處理請聯系客服。電話:028-86922220;郵箱:631063699@qq.com。內容未經允許不得轉載,或轉載時需注明來源: 創新互聯

- Bluehost雙十二不限流量虛擬主機低至23.6元 2022-10-11

- 網站建設之虛擬主機 2021-05-30

- 虛擬主機的優勢? 2022-07-26

- 網站建設時虛擬主機和服務器應該如何選擇? 2016-11-07

- 怎樣選擇好的虛擬主機 2016-04-24

- 美國主機穩定性怎么樣?美國虛擬主機如何選擇? 2022-10-04

- 免費的虛擬主機和域名怎么樣?可信嗎? 2021-02-10

- 虛擬主機影響網站SEO優化的因素 2023-03-29

- LNMP添加、刪除虛擬主機及偽靜態使用教程 2022-10-02

- 虛擬主機流量會受到什么限制? 2022-10-06

- 企業為什么要用獨享ip虛擬主機? 2021-03-15

- 虛擬主機與云服務器 2021-02-14