Python如何自動化登錄網站并爬取商品數據

這篇文章主要為大家展示了“Python如何自動化登錄網站并爬取商品數據”,內容簡而易懂,條理清晰,希望能夠幫助大家解決疑惑,下面讓小編帶領大家一起研究并學習一下“Python如何自動化登錄網站并爬取商品數據”這篇文章吧。

創新互聯公司成立以來不斷整合自身及行業資源、不斷突破觀念以使企業策略得到完善和成熟,建立了一套“以技術為基點,以客戶需求中心、市場為導向”的快速反應體系。對公司的主營項目,如中高端企業網站企劃 / 設計、行業 / 企業門戶設計推廣、行業門戶平臺運營、成都App定制開發、手機網站制作設計、微信網站制作、軟件開發、成都天府聯通服務器托管等實行標準化操作,讓客戶可以直觀的預知到從創新互聯公司可以獲得的服務效果。

適合閱讀人群:

selenium工具的使用

結構化的數據解析

csv數據保存

環境介紹:

python 3.6

pycharm

selenium

csv

time

selenium

起初是用來做網頁測試(性能\并發),可以直接獲取到瀏覽器渲染之后的數據(不用解密)

用戶行為和你代碼邏輯需要結合(你怎么操作瀏覽器)

谷歌驅動器

受害目標

https://www.jd.com/

部分代碼

from selenium import webdriver

import time

import csv

def parse_product():

"""解析商品數據"""

lis = driver.find_elements_by_css_selector('.gl-warp.clearfix>li')

for li in lis:

try:

name = li.find_element_by_css_selector('.p-name a em').text # 商品的名字

price = li.find_element_by_css_selector('.p-price strong i').text + '元' # 商品的價格

info = li.find_element_by_css_selector('.p-commit strong a').text # 商品的評價數

title = li.find_element_by_css_selector('.J_im_icon a').get_attribute('title') # 商品的店鋪

print(name, price, info, title)

with open('data.csv', mode='a', encoding='utf-8', newline='') as f:

f.write()

csv_write = csv.writer(f, delimiter=',')

csv_write.writerow([name, price, info, title])

except Exception as e:

print(e)

def get_next():

"""找到下一頁標簽, 點擊"""

driver.find_element_by_css_selector('#J_bottomPage > span.p-num > a.pn-next > em').click()

driver.implicitly_wait(10)

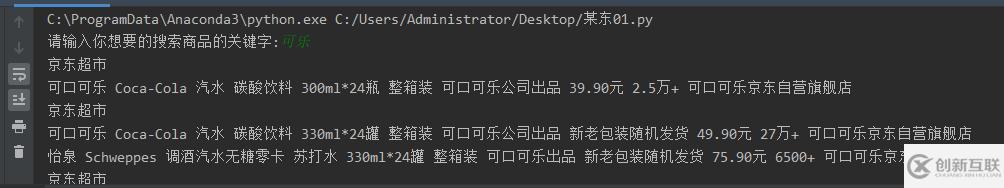

keyword = input('請輸入你想要的搜索商品的關鍵字:')

driver = webdriver.Chrome() # 創建一個瀏覽器對象

driver.get('https://www.jd.com/')

get_product(keyword)

for page in range(1, 101):

drop_down()

parse_product()

get_next()運行代碼得到數據

以上是“Python如何自動化登錄網站并爬取商品數據”這篇文章的所有內容,感謝各位的閱讀!相信大家都有了一定的了解,希望分享的內容對大家有所幫助,如果還想學習更多知識,歡迎關注創新互聯行業資訊頻道!

網頁名稱:Python如何自動化登錄網站并爬取商品數據

文章轉載:http://m.kartarina.com/article16/jeccdg.html

成都網站建設公司_創新互聯,為您提供商城網站、網站維護、響應式網站、用戶體驗、標簽優化、網站內鏈

聲明:本網站發布的內容(圖片、視頻和文字)以用戶投稿、用戶轉載內容為主,如果涉及侵權請盡快告知,我們將會在第一時間刪除。文章觀點不代表本網站立場,如需處理請聯系客服。電話:028-86922220;郵箱:631063699@qq.com。內容未經允許不得轉載,或轉載時需注明來源: 創新互聯

- 外貿建站選韓國vps主機適合嗎? 2022-10-07

- 外貿建站和推廣如何做 2021-01-28

- 做外貿建站好不好?這幾個誤區要注意了 2015-04-27

- 成都網站建設過程中關于外貿建站 2018-06-13

- 外貿網站建站費用是由那些方面組成的?外貿建站報價多少靠譜? 2015-07-09

- 開發好的APP如何獲取用戶,告訴你了你也不一定領悟明白! 2022-06-02

- 詮釋網站排名的高低與流量多少之間的關系 2022-06-24

- 外貿建站租用香港云服務器還是美國云服務器好? 2022-10-02

- 成都外貿建站公司哪家好? 2015-03-21

- 外貿建站前必看的四大技巧及優化系統 2022-05-27

- 外貿建站中的哪些細節影響著網站流量? 2015-06-11

- 外貿建站的推廣方式有哪些 2016-04-18